Ergebnis 101 bis 120 von 184

-

08.11.2022, 18:11 #101swagni

Nvidia GeForce RTX 40X0-Serie

Die YTer testen doch immer auf Testbenches, oder? Oder auch mal mit abgeknicktem Kabel in einem geschl. Gehäuse?

-

-

08.11.2022, 18:43 #102Dragonfire

Nvidia GeForce RTX 40X0-Serie

Stark geknickte Kabel wurden von mehreren getestet.

Obs einer im geschlossenen Gehäuse getestet hat, glaub ich nicht. Geht ja auch schlecht, wenn man Temperaturen und co. messen und beobachten will.

Aber worauf willst du hier hinaus? Dass die Karte im kleinen Raum erstickt und sich so aufheizt, dass das Plastik vom Adapter schmilzt? Dir ist bewusst, dass die 4090 allein schon durch die schiere Größe in nichts passt, was vom Volumen her nicht fast an einen Big-Tower grenzt?

Und die wenigen Betroffenen, die tatsächlich ihr System fotografiert haben (und nicht nur den Adapter mit mehr Finger sichtbar als Plastik), hatten guten Airflow und das Kabel war meist auch nicht übermäßig stark geknickt.

Von dem her nein: Es ist einfach kein eindeutig und schnell identifizierbares Problem...

-

08.11.2022, 19:10 #103swagni

Nvidia GeForce RTX 40X0-Serie

Unmöglich wärs nicht, aber umständlich. ABer vielleicht stelle ichs mir zu einfach vor.

Natürlich, aber wenn zb. das geknickte Kabel gegen ein Sidepanel drückt und sich dadurch das Ganze mehr aufheizt als bei div. Tests, dann sind die Tests aufgrund der Methodik nicht dazu geeignet den Defekt zu replizieren.

Naja dann ist es wohl wirklich sehr kompliziert, vielleicht sind einfach Montagsstecker dabei und das ist der Fehler.

Es bleibt mysteriös.

-

08.11.2022, 19:18 #104Dragonfire

Nvidia GeForce RTX 40X0-Serie

Das ist ja die Sache. Es ist ein verdammter Kontaktstecker. Der muss nichts können, außer den Strom stabil von Kabel zu Karte übertragen. Das ist keine Raketenwissenschaft.

Das "Kritische" sind sechs mal 12V Pins und sechs mal Ground. Und ich geh doch davon aus, dass die Leute, die diesen Stecker ausgelegt haben, das Tabellenbuch richtig rum gehalten haben, um herauszufinden, was die nötigen Querschnitte für die angepeilten Ströme sind.

Ich hab als Maschinenbauer jetzt kein allzu großes Verständnis von reiner Elektrik, aber für mich ist das ein Problem des Kontaktwiderstands oder eben zu geringer Kontakt. Wo die Leute gucken müssen, ist also sehr limitiert.

Ich mein, ich werf jetzt auch einfach mal ne wilde Theorie in den Raum: Vielleicht haben manche Stecker unreines Material und die Kontakte sind an der Seeluft oxidiert, was jetzt bei manchen Leuten zu hohen Kontaktwiderständen und damit extremer Hitze führt? Wenns so ein obskurer Fehler ist, wird es lange dauern, bis man sowas eindeutig identifiziert.

Wie ich auf die Idee komme? Weil ich den Fehler selbst erlebt habe, wo in in einem Projekt Maschinen mit rostfreiem und beständigem Edelstahl gefertigt wurden, der beim Kunden nach kurzer Zeit das Rosten anfing.

Wahrscheinlicher sind aber wohl zu große Toleranzen und Leute die es jetzt erwischt hat, hatten das Pech zu große Buchsen für zu kleine Stifte zu bekommen. Aber auch das lässt sich schwer überprüfen, wenn z.B. eine Charge außerhalb der Toleranz durchgerutscht ist und diese längst bei den Kunden ist.

-

08.11.2022, 19:44 #105swagni

-

08.11.2022, 20:20 #106Dragonfire

Nvidia GeForce RTX 40X0-Serie

Ja, solche Untersuchungen fallen in das Gebiet der Metallographie. Hier wird ein Bauteil durchgeschnitten, die Oberfläche geschliffen und poliert und dann mit dem Mikroskop betrachtet.

Dinge wie Verunreinigungen im Material und auch Korrosion lassen sich damit recht leicht aufdecken.

https://www.qa-group.com/de/leistung...etallographie/

Aber wie gesagt: Eine sehr wilde Theorie.

-

09.11.2022, 11:31 #107Dragonfire

Nvidia GeForce RTX 40X0-Serie

PCI-SIG gibt Änderung des 12VHPWR-Steckers bekannt.

Erste Kabelhersteller setzen bereits die neue Version um.

Was wurde geändert? Die Plastik-Einhausung wurde im Bereich der Sense-Pins erweitert und verstärkt.

Alter Stecker:

Neuer Stecker:

https://help.moddiy.com/en/article/a...ector-1r10y16/

Was nicht bekannt ist, ob diese Änderung als Lösungs-Ansatz für geschmolzene Adapter gedacht ist. Aber unwahrscheinlich, da vor allem der Nvidia-Adapter etwas anders aufgebaut ist.

Nutzer können den Stecker durch die Änderung aber besser greifen und sicherer einstecken. Ebenso dürften vor allem die vier Sense-Kabel etwas besser gegen Knicke, etc. geschützt sein.

Edit: Ah scheint etwas älter zu sein. Corsair und co. haben anscheinend schon längst die verstärkten Stecker, zumindest den Produktfotos nach. Weiß nicht, warum die News jetzt aufploppt.

-

09.11.2022, 17:38 #108Dragonfire

Nvidia GeForce RTX 40X0-Serie

Linus Tech Tips hat sich DLSS 3 Frame Generation angeschaut, ebenfalls inkl. Mitarbeiter-Blindtest.

Das Fazit ist eher positiv, auch wenn Frame Generation noch einige Kinderkrankheiten hat.

Die größte Schwäche ist wohl, dass Frame Generation aktuell besser mit hohen Ausgangs-Framerates funktioniert. Günstige Einsteiger-GPUs, die diesen FPS-Boost also wirklich nötig hätten, werden von DLSS 3 weniger profitieren, bzw. sie werden sich mit stärkeren visuellen Artefakten, etc. abgeben müssen. Die Framerate sollte mindestens "spielbar" sein, bevor man Frame Generation aktiviert, aber je höher desto besser.

Frame Generation wird außerdem wenig in kompetitiven Multiplayer-Shootern helfen, da es beim Input-Lag nicht hilft. Aber Singleplayer-Spiele, die man vielleicht sogar mit dem Controller spielt, werden von der gewonnenen Framerate profitieren. Viele der Artefakte gehen auch oft in Dingen wie Motion Blur unter und bleiben dadurch unbemerkt. Und selbst wenn: Eine niedrige Auflösung, bzw. reduzierte Grafiksettings würden wohl stärker auffallen, als die Artefakte.

Ich bin in der Hinsicht auch wahnsinnig auf FSR3 von AMD gespannt. Und mal sehen, was Intel macht... Ich finde das ganze Thema um modernes Upscaling und jetzt Frame Generation jedenfalls super spannend und auch wegweisend. Je mehr große Player da in die Richtung pushen, desto schneller werden diese Technologien besser.

Nvidia hat's ja in ihrer Präsentation genannt, aber im aktuellen Extrem-Fall (DLSS 2 "Performance + DLSS3 Frame Generation) wird nur noch einer von acht Pixeln tatsächlich gerendert... und am Ende kommt schon jetzt ein, zwar nicht fehlerfreies, aber trotzdem überzeugendes Bild dabei raus. Der Leistungsgewinn ist schon aufregend, wenn man die Qualität weiter optimieren kann.

-

09.11.2022, 18:42 #109Jonny Knox

Nvidia GeForce RTX 40X0-Serie

Der Vorteil ist, wenn eh nur 12,5% echte Pixel sind, kann man die anderen ja für andere Dinge verwenden.

-

10.11.2022, 14:34 #110HardAndSoft

Nvidia GeForce RTX 40X0-Serie

Neue Erklärung für die geschmolzenen Stromstecker:

Der Corsair-Netzteilspezialist hat alle möglichen Konstellationen bzgl. geknickter oder beschädigter Stecker durchprobiert - ohne Ergebnis. Er vermutet jetzt, dass die beschädigten Stecker einfach nicht sauber eingesteckt/eingerastet waren. Ein sogenanntes "Layer 5-Problem". Das würde erklären, warum Nvidia so lange für eine Lösung braucht.

Das würde erklären, warum Nvidia so lange für eine Lösung braucht.

https://www.pcgameshardware.de/Gefor...ecker-1407011/

-

10.11.2022, 15:27 #111medeman

Nvidia GeForce RTX 40X0-Serie

Die Probleme auf die User zu schieben wäre schon ein starkes Stück.

Wenn man so einfach was "falsch" machen kann, dann ist es schlecht designt.

-

10.11.2022, 19:11 #112Dragonfire

Nvidia GeForce RTX 40X0-Serie

Aber auch hier wieder nur eine Vermutung und vermutlich eher aus der Luft gegriffen: Es wird kein Beweis erbracht. Man sollte es doch schaffen, auch schlecht eingesteckte Stecker zu simulieren, wenn man eh schon tief in Tests drin steckt?! Da schneidet man Kabel ab, bricht Lötstellen auf und lässt rohe Gewalt auf den Adapter einwirken... aber das Ding mal einfach mal nur zur Hälfte oder schief einstecken, steht nicht auf dem Plan?

Die Einzigen die den Stecker tatsächlich stark erhitzt haben - aber auch nicht bis zum Schmelzpunkt - war das vom Grafikkartern-Hersteller GALAX gesponsorte OC-Team TecLab... und die haben am Ende über mehrere Minuten 1.200-1.400 Watt durch einen stark malträtierten Adapter gejagt. Sobald sie wieder auf 600 Watt reduziert haben, ist der Stecker aber schnell wieder auf unbedenkliche Temperaturen abgekühlt. War zudem auch ein sehr theoretischer Test, da ohne Grafikkarte, sondern nur mit dem Stecker/Nvidia-Adapter am Laborgerät.

-

10.11.2022, 19:24 #113HardAndSoft

Nvidia GeForce RTX 40X0-Serie

Wenn man den Originalbeitrag auf Tom's Hardware liest, dann bemüht sich der Corsair-Spezialist deutlich, das Problem nicht allein auf die User zu schieben. Er sagt, genau dieser Stecker sei sehr, sehr schwer einzustecken - im Prinzip also wie Du schon sagst ein Designfehler.

Link zu Toms Hardware: https://www.tomshardware.com/news/co...connector-gate“ANY 12VHPWR connector can potentially burn up because ANY of them can be hard to insert.” This theory was supported by a number of connector mating images where the connector isn’t quite fully inserted. Moreover, he reasoned that the 16-pin connector is “VERY DIFFICULT to insert completely,” which jives with our own experience. The caps-lock in both previous quotes has been left intact for emphasis.

-

10.11.2022, 23:16 #114Dragonfire

Nvidia GeForce RTX 40X0-Serie

Er ist das letzte Stück, vor dem Einrasten sehr stramm. Das stimmt auf jedenfall. Da ist so gut wie kein Spiel in dem Stecker... aber man sieht am deutlich nach oben gebogenen Haken, dass er noch nicht eingerastet ist. Und mir kann auch niemand erzählen, dass der Stecker so wenig Fehlertoleranz hat, dass 1-2mm zu wenig direkt brandgefährlich werden. Aber wenn es wirklich daran liegt und tatsächlich ein Designfehler ist: Von all den verrückten Versuchen, die wir von Youtubern, etc. gesehen haben, das wäre doch das Einfachste zum überprüfen und zwar reproduzierbar.

Vor allem, wenn man sich als Netzteil-Experte hinstellt und mit Capslock in die Menge brüllt, das JEDER Stecker betroffen ist. Ich find's interessant, dass Corsair hier zulässt, dass der Typ so Panik schürt, wo sie doch selber diese Stecker verkaufen. Aber ok... die haben sich letzten Monat schonmal öffentlich entschuldigen müssen, weil ein Mitarbeiter Fehlinformationen über den Stecker verbreitet hat und dabei gleichzeitig noch Gamers Nexus und Guru 3D schlecht machen wollte.

Versteht mich nicht falsch, als 4090-Nutzer würde ich schon gern endlich wissen, ob es wirklich ein weitreichendes Problem ist, das jeden betreffen könnte. Aber was hilft es, wenn man als Internetpräsenz mit bekanntem Hersteller-Namen im Rücken große Torture-Tests macht, auf kein Ergebnis kommt und dann sagt "Keine Ahnung... wahrscheinlich User schuld, weil Design scheiße"?

Interessant bleibt, was Nvidia macht. In nichtmal einer Woche kommt die 4080... völlig egal wie das Ding sich schlägt: Thema Nr. 1 wird dieser Stecker sein.

Und im Januar kommen dann Data-Center-GPUs von Intel mit dem Anschluss. Die werden auch bemüht sein, das Problem aus der Welt zu schaffen. Die waren ja auch an der Entwicklung beteiligt.

-

11.11.2022, 14:24 #115Dragonfire

Nvidia GeForce RTX 40X0-Serie

Igor teased auf Youtube, dass er mit asiatischen Herstellern und Zulieferern in Kontakt steht, will aber noch nicht damit rausrücken, was er rausgefunden hat.

"Und ja, es ist NICHT der 12VHPWR an sich, sondern es könnte ganz simpel sein."

https://www.youtube.com/c/igorsLAB/community

Noch ne neue Theorie zu einem Bauteil, das aus nichtmal nem Dutzend unterschiedlicher Komponenten besteht? Hau raus, Igor! Aber Kontakt zu den Leuten, die diesen Stecker produzieren wär immerhin mal was Neues in der Geschichte.

Die Frage ist, ob man da irgendwas rausbekommt, oder ob die sich eher selbst schützen wollen?

Ich glaube inzwischen ja, dass Lisa Su ne Voodoopuppe mit Jensen-Lederjäckchen im Keller hat und Nachts das Feuerzeug drunter hält, was dann irgendwo auf der Welt zufällig nen 12VHPWR-Anschluss hochgehen lässt.

-

14.11.2022, 15:53 #116Dragonfire

Nvidia GeForce RTX 40X0-Serie

Großer Artikel von Igors Lab zum 12VHPWR-Adapter.

Igor steht direkt mit Nvidia und Boardherstellern in Kontakt.

In Sachen Nvidia-Adapter gibt es zwei Hersteller. Einer davon ist aufgrund seines Design der Federkontakte in der Theorie etwas sicherer.

Die Fehler beim Löten, die Igor zu Beginn aufgedeckt hat, dürften eigentlich so gar nicht auftreten. Das ist wohl auf einen einzigen Mitarbeiter zurückzuführen, der gegenüber der Vorgabe schlichtweg falsch gelötet hat. Das ist wohl auch der Grund, warum andere wie Gamers Nexus diesen Fehler nicht bestätigen konnten. Dennoch bleibt das verlötete Design des Adapters grundlegend sehr fragwürdig... Der ganze Adapter sei nicht mehr, als eine "Notlösung".

Aber auch mit diesem Wissen gibt es kein eindeutig identifizierbares Problem, sondern eher eine Aneinanderreihung von mehreren Problemen, angefangen beim "weltfremden" und unerprobten Design des festgelegten 12VHPWR-Standards, über Mängel in der Fertigung beim Nvidia-Adapter, bis hin zu Problemen beim Nutzer, u.A. hervorgerufen von schwer zugänglichen Steckern aufgrund des Kühlerdesigns einiger Karten.

Die PCI-SIG hat derzeit immerhin schon eine Änderung des Steckers auf den Weg gebracht. Dieser verlagert die Sense-Pins etwas nach hinten. Ist der Stecker nicht komplett eingesteckt, springt die Grafikkarte also gar nicht erst an.

Nvidia wollte laut Igor ursprünglich auch einen anderen Stecker verwenden (10-Pin-Molex), wurde aber in der PCI-SIG überstimmt. Dass man sich jetzt so auf den neuen Stecker eingefahren hat, lag aber auch daran, dass es bei der 3000er-Serie kein negatives Feedback gab.

https://www.igorslab.de/guter-oder-s...-investigativ/

-

15.11.2022, 15:40 #117Dragonfire

Nvidia GeForce RTX 40X0-Serie

Die Reviews zur 4080 sind da.

Fazit auf den ersten Blick: Effiziente Karte mit viel Leistung für einen scheiß Preis.

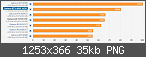

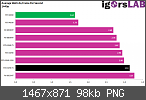

Performance-Index von PCGH.

Raster-Performance (20 Spiele in vier Auflösungen).

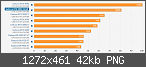

Raytracing-Performance (10 Spiele in vier Auflösungen)

https://www.pcgameshardware.de/Gefor...Preis-1407013/

Igor hat auch Effizienz-Tabellen (benötigte Watt pro Frame).

Hier z.B. für 1440p.

https://www.igorslab.de/nvidia-gefor...s-befuerchtet/

Und achja... das ist eine 300 Watt-Karte mit einem 600 Watt-Kühler! Kühlerdesigns von Founders Edition und Boardpartner sind zur 4090 unverändert und schon bei der 4090 war die Kühlung überdimensioniert.

-

15.11.2022, 19:18 #118medeman

Nvidia GeForce RTX 40X0-Serie

Alle Auflösungen vergleichen führt hier zu einem verfälschten Ergebnis, weil bei einigen Spielen entweder beide Karten oder nur die 4090 in ein CPU-Limit läuft. Ist also nur relevant, wenn man wirklich in einer spezifischen Auflösung < 4KUHD spielen möchte. Die Karte ist laut einigen Reviewern (Hardware Unboxed, Gamers Nexus) so um die 70% so schnell wie eine RTX 4090, laut PCGH in 4K immerhin 75%, was dann mehr oder weniger zu einer 1:1 Skalierung von Leistung zu Preis führt (was natürlich totaler Quatsch ist, weil das P/L-Verhältnis der XX90er bzw. Titan-Karten noch nie gut war und sich die XX80er-Karten auch nie daran orientiert haben).

Bei einigen Karten stimmt das zwar, bspw. die ASUS 4080 TUF wiegt aber 400 Gramm weniger (davon 308 Gramm der Kühler), der Vapor Chamber fehlt und 6 der 8 Heatpipes sind nur noch 6mm statt 8mm im Durchmesser.

Die Karte ist das Geld finde ich auf keinen Fall wert, wird aber trotzdem gekauft oder dient eben dem Upselling zur 4090. Solange das funktioniert gibt es für Nvidia keinen Grund, die Preise zu reduzieren. Und solange Nvidia nicht irgendwelche neuen Zwischennamen wie eine "4065 Ti Super" und Co. erfindet, werden sie mit einem Lineup von 4090 > 4080 Ti > 4080 > 4070 Ti > 4070 > 4060 Ti > 4060 > 4050 auch niemals eine preiswerte 4050 herausbringen, und das ist eigentlich das größte Problem. Dann ist die GTX 1060 in den nächsten 2 Jahren bei Steam eben immer noch in den Top 3

-

15.11.2022, 20:15 #119Dragonfire

Nvidia GeForce RTX 40X0-Serie

Es ist ein einfacher Rundumschlag der "alles" abdeckt, bzw. eben 20 Spiele in vier unterschiedlichen Auflösungen... Wer spezifischere Fälle sehen will, muss schon selbst in den Test gucken, wo ja dann auch alles genauer beschrieben ist. Ich finde den Leistungsindex als blitzschnellen Ersteindruck jedenfalls seit Jahren sehr praktisch.

Jupp, inzwischen sind ja auch mehrere Berichte zu Partnermodellen online gegangen. Hab vorhin nur das Video von der8auer angeschaut und der hatte die Strix. Und hier scheint der Kühler praktisch identisch zu sein, bei der TUF hat man dann aber wohl doch mehr eingespart.

Auf dem Board selbst und bei der Stromversorgung gibt es aber natürlich größere Anpassungen... seine Strix hat auch deutlich hörbares Spulenfiepen. Etwas, dass die 4090 Strix nicht in dem Ausmaß hatte.

Ich fühl mich als 4090-Käufer jedenfalls bestätigt. Und im Highest-End-Bereich zeigt sich auch irgendwie anderes Bild als bei den typischen Gaming-Karten. Hier sind die Preise ja eigentlich gefallen, wenn man es noch mit den Titan-Karten vergleicht. Eine Titan RTX z.B. hat vor nur zwei Generationen bereits 2.700 Euro gekostet und hat im Prinzip auch nicht mehr geboten, als jetzt eine "günstigere" RTX 4090 im Vergleich zur nächst kleineren Karte.

Und im Highest-End-Bereich zeigt sich auch irgendwie anderes Bild als bei den typischen Gaming-Karten. Hier sind die Preise ja eigentlich gefallen, wenn man es noch mit den Titan-Karten vergleicht. Eine Titan RTX z.B. hat vor nur zwei Generationen bereits 2.700 Euro gekostet und hat im Prinzip auch nicht mehr geboten, als jetzt eine "günstigere" RTX 4090 im Vergleich zur nächst kleineren Karte.

Und in dieser zweithöchsten Performance-Klasse frag ich mich auch, ob die Konkurrenz von AMD hier überhaupt groß was ändern kann, ändern will... ja, die 7900XTX wird ziemlich sicher das bessere Gesamtpaket für doch ganze 200 Dollar (und vermutlich 200 Euro) weniger... aber spielt das wirklich eine Rolle? Auch die 7900XTX wird hierzulande wohl mit mindestens 1.250 Euro auf dem Markt einschlagen. Die kleinere 7900 XT dann halt 100-150 Euro weniger. Das sind doch einfach keine Preisbereiche mehr, wo es noch große Kämpfe um Marktanteile gibt. Ich vermute daher, dass der von vielen angepriesene Arschtritt für Nvidia ausbleiben wird. Vor allem, wenn man sich in Teilbereichen doch noch absetzen kann, z.B. Raytracing.

Ich bin wirklich gespannt, was da in der Mittelklasse ablaufen wird. Und vor allem mach ich mir Sorgen um den Wachstum des Gaming-PC-Markts. "Wir" haben endlich einen Punkt erreicht, wo der PC für einige Publisher sogar schon die wichtigste Platform darstellt (z.B. Capcom). Es wäre schade, wenn das jetzt ausgebremst wird.

-

15.11.2022, 20:56 #120medeman

Nvidia GeForce RTX 40X0-Serie

Ich finde den auch super als ersten Vergleich, aber gerade bei den Karten die jetzt rauskommen fällt der bei 1080p (und teilweise bei 1440p) etwas auseinander.

Ja, die Titan-Karten (und für mich sind die XX90er-Karten eigentlich neu benannte Titan-Karten) waren aber eben auch noch nie für ihr gutes Preis-/Leistungsverhältnis bekannt, sondern eben dafür, die Spitze des Eisberges zu sein. Da ist der Preis dann bis zu einem gewissen (großzügigen) Rahmen egal. Aber die XX80er-Karten hatten historisch ein deutlich besseres Preis-/Leistungsverhältnis im Vergleich zu den Titan/XX90-Karten. Die 3080 hat zu "normalen" Preisen - wenn man sie denn bekommen hat - die Hälfte (je nach Modell nicht mal das) einer 3090 gekostet. Und die 3090 war...um die 15% schneller? Die Preis-/Leistung war zumindest ausgegangen von der UVP ziemlich gut. Bei der 3070 und 3060 Ti ebenfalls. Zum Zeitpunkt des 3060 Launchs und vor allem des 3050 Launchs hat Nvidia die UVPs dann an die überteuerten Straßenpreise angenähert. Die 2000er-Serie war jetzt nicht so super von der Preis-/Leistung, vor allem, weil man mit den RT Cores anfangs kaum was anfangen konnte. Das hat sich aber doch recht schnell gebessert, vor allem mit den "Super" Refreshs. Die GTX 1000er-Serie war eigentlich auch "preiswert", selbst die 1080 Ti hatte einen fairen Preis (und der Launch selbiger hat den Preis der 1080 ordentlich gedrückt).

Jetzt kostet die neue XX80er-Karte (4080) UVP $1.199 bzw. 1.469,-€, der Straßenpreis bzw. die Partnermodelle liegen oft deutlich darüber. Und der relative Abstand der 4080 zur 4090 ist auch noch deutlich größer als der relative Abstand der 3080 zur 3090.

Frage ich mich auch. Ich freue mich auf die Reviews zur 7900 XTX, aber nüchtern betrachtet ist die Karte natürlich auch keine, die das Preis-/Leistungsniveau auf "vor Ende 2020" zurückbringen wird, vor allem in Europa nicht. $999 zzgl. Mehrwertsteuer sind ca. 1.150,-€, aber kann mir auch gut vorstellen, dass die tatsächliche UVP bzw. vor allem der tatsächliche Verkaufspreis irgendwo zwischen 1.200,-€ und 1.300,-€ losgeht, weil die Hersteller sich bei der Umrechnung von Dollar in Euro ja gerne mal einen guten Puffer lassen.

Was die Software und die Services angeht, wird der PC doch immer attraktiver denke ich. Beziehungsweise werden Konsolen mit teureren Spielepreisen und mehr/teureren Abos (und Hardwarepreisen und Verfügbarkeit) finde ich immer unattraktiver. Wären da nicht auch die Preise für PC-Hardware. Die Mittelklasse ist ja mittlerweile die unterste Klasse, die es noch gibt. Mit ach und krach kannst du dir einen Gaming-PC für um die 600,-€ zusammenstellen, aber da hast du dann auch echt viel eingespart in Sachen Gehäuse, Netzteil, Mainboard und Co. Wie gesagt, die GTX 1060 Nutzer haben nicht wirklich was zum upgraden, bis auf die RX 6600 ab 265,-€ vielleicht. Auf Nvidias Seite kostet die RTX 3050 ab 280,-€, und das sollte keiner dafür ausgeben. Unter der 3050 gibt es quasi nichts (okay, eine 1660 Super für 5,-€ weniger, aber ist ja auch kompletter Quatsch). Und wenn die 4080 preislich schon so weit über der 3080 liegt, wie weit wird die 4050 dann über der 3050 liegen?

Ähnliche Themen

-

Fermi ist da! Nvidia GeForce GTX 470 und GTX 480: Nvidia hat nun offiziell die neuen DirectX 11 - Grafikkarten GTX 470 und GTX 480 vorgestellt. Die bisher als "Fermi" bekannten Grafikkarten sollen... -

NVidia GeForce GTX480: Ich hoffe mal, dass die das wirklich bis zum 26.3 schaffen :D NVIDIA GeForce GTX 480 and GTX 470 Fermi cards launching March 26th -- Engadget ... -

NVIDIA GeForce 8700M GT: hiho leute. habe ma wieder ein prob mit meinem laptop ^^ also ich wollte mir den treiber für meine grafikkarte installieren, der funktioniert aber... -

Problem, nach Vista Update bzw. (nVidia - Display - NVIDIA GeForce 9600 GT ): Hi, hab hier n Rechner auf dem die Home premium Vista Version läuft, bin ein Counterstrike Source-Spieler, heute kam kein neues Update dass eben... -

nVidia Geforce 9600GT: ich von einem Kollegen gehört die 9000er Serie sollte sich wirklich rentieren, was ich bei der 9600 allerdings bezweifle, denn um den Preis als neue...

Ich habe zu keinem Zeitpunkt behauptet dass aus meiner Sicht die Wehrmacht keine Kriegsverbrechen beging. Offiziell war vermutlich der ganze Krieg...

Alternative für Deutschland